AI数据中心

建设新型信息化基础设施,打造一所面向人工智能领域的专属AI数据中心,为AI产业发展与融合提供扎实、充足的算力支持。

一、项目背景

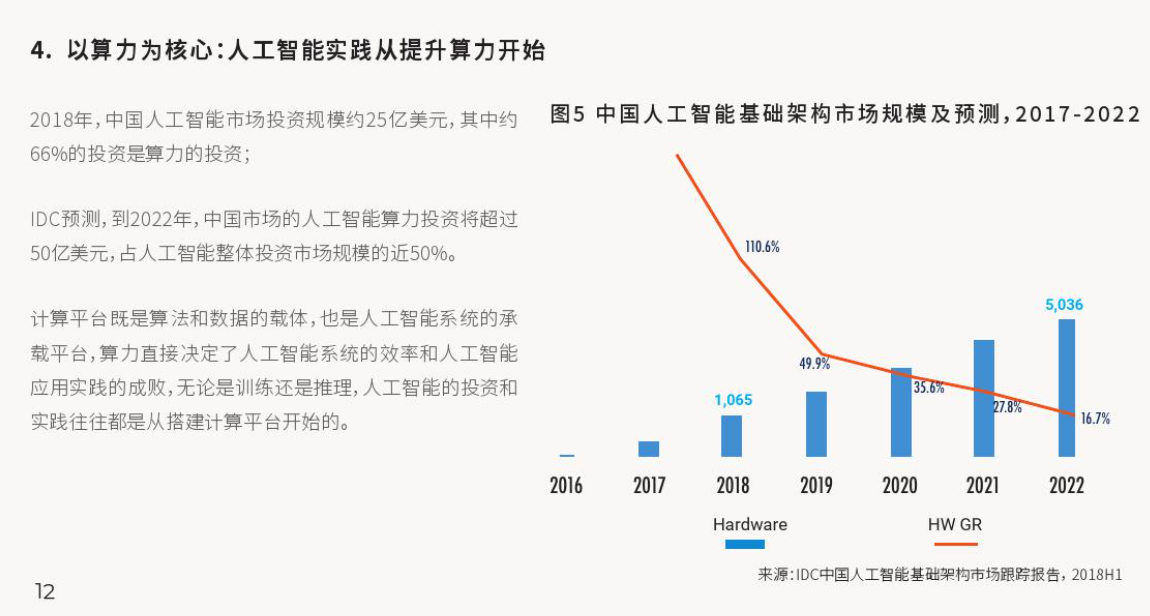

人工智能算力,作为承载人工智能应用的平台和基础,是人工智能的最核心要素之一,算力的突破能够带动整个人工智能行业的发展和快速演进。根据预测,2022年全球人工智能市场中用于算力的投资将超过176亿美金,该市场未来五年的复合增长率将超过30%。其中对我国在人工智能算力市场的投资预测达到50亿美金,占我国人工智能整体投资市场规模的近50%,进一步印证算力在人工智能行业发展的重要意义。

2021年3月11日,十三届全国人大四次会议表决通过了《关于国民经济和社会发展第十四个五年规划和2035年远景目标纲要》的决议,其中强调了”加快构建全国一体化大数据中心体系,强化算力统筹智能调度,建设若干国家枢纽节点和大数据中心集群,建设E级和10E级超级计算中心”。

2021年5月24日,国家发改委发布了《全国一体化大数据中心协同创新体系算力枢纽实施方案》,方案中指出,“在京津冀、长三角......发展数据中心集群,引导数据中心集约化、规模化、绿色化发展……加强云算力服务、数据流通、数据应用、安全保障等方面的探索实践,发挥示范和带动作用”。

无锡市作为国务院批复的长三角中心城市之一,积极响应党和国家的发展政策,大力布局数据中心建设。早在2020年,无锡市政府就已在《关于加快推进数字经济高质量发展的实施意见》中提出,把“建设数据应用新型基础设施。加快人工智能技术创新,推动人工智能算法研究,探索数据算法库建设,提升海量数据应用能力”作为无锡市重点任务之一。

因此在该背景下,建设新型信息化基础设施,打造一所面向人工智能领域的专属AI数据中心,为AI产业发展与融合提供扎实、充足的算力支持是十分必要的。

二、项目介绍

建设目标

无锡AI创新赋能中心——AI数据中心项目,是基于NVIDIA公司的《NVIDIA DGX SuperPOD: Scalable Infrastructure for AI Leadership》所建议的技术架构进行规划、设计和建设实施,通过部署NVIDIA DGX A100超级计算机、NVIDIA Mellanox IB交换机、AI7990存储平台及其他配套设备系统,使AI数据中心具备国内顶尖的“高速计算、高速网络、高速存储”能力,AI数据中心的愿景是发展成为人工智能模型训练和推理部署垂直领域国内最专业的AI算力平台。

建设规模

AI数据中心计划共进行三期建设,占地面积约500平方米,总投资约1亿元人民币,其中一期建设投资约3700万元人民币,目前已完成AI数据中心整体工程建设并部署了12台DGX A100高性能AI服务器,集群峰值算力高达60 PetaFLOPS(6亿亿次AI算力),预计在三年内扩充至40台DGX A100以上(或采用更新一代DGX产品),即达到200千万亿次以上AI算力。

无锡AI创新赋能中心-AI数据中心实景

建设内容

DGX SuperPOD 技术架构

AI数据中心所有的系统在设计建设时统一规划。本项目三年期建设都将基于《NVIDIA DGX SuperPOD: Scalable Infrastructure for AI Leadership》所建议的技术架构,根据算力需求的增长灵活动态扩展。

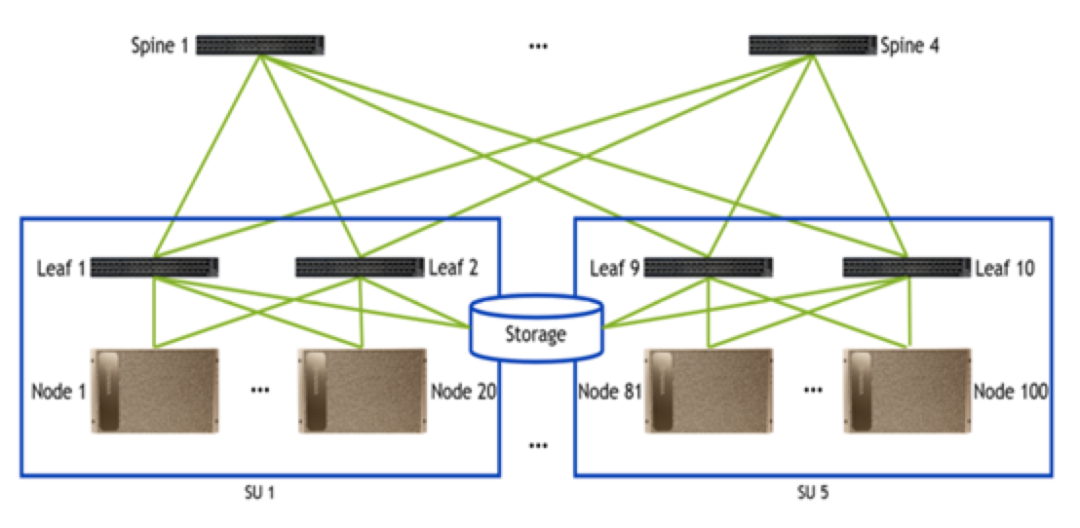

NVIDIA已将SuperPOD模块化,NVIDIA DGX A100与Mellanox IB交换机及DDN高速存储系统的技术架构极具灵活性与可扩展性,每个扩展组均由使用Mellanox HDR InfiniBand的二层胖树(two-tiered fat-tree)交换网络拓扑提供支持,提供完整的对分宽带,且没有过载(oversubscription)。下图所示为5个DGX A100系统扩展组共计达到100个DGX A100节点的SuperPOD架构:

在添加第三个交换层后,用户可以在NVIDIA的扩展参考设计中使用DragonFly+或胖树拓扑将其扩展至数千个节点。NVIDIA SuperPOD技术让我们能够重新定义数据中心,支持“用户按需弹性购买AI算力服务”,同时实现“数据中心按业务增长动态扩展算力基础设施”,使得数据中心基础设施扩展变得更为轻松,最大程度地减少其对业务运营的影响。

DGX A100计算节点

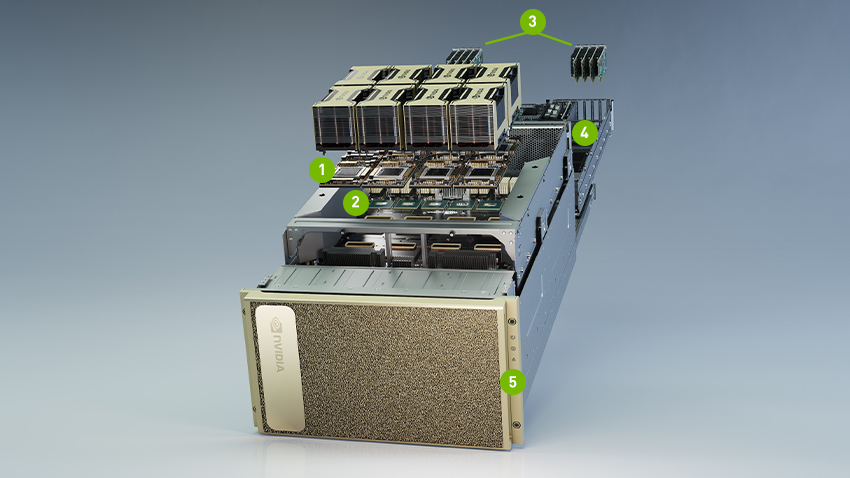

AI数据中心所采用的DGX A100高性能服务器,是NVIDIA于2020年5月发布的,基于最新NVIDIA Ampere(安培)GPU架构的超级计算机,也是AI技术演进历程中的巨大飞跃和重要里程碑。

DGX A100包含极其强大的功能组件:

八块 NVIDIA A100 GPU,GPU 总显存高达 640 GB,每块 GPU 支持 12 个 NVLink 连接, GPU 至 GPU 带宽高达 600 GB/s;

六个第二代 NVSWITCH,双向带宽高达 4.8 TB/s, 比上一代产品高出 2 倍;

九个 Mellanox ConnectX-6 VPI HDR InfiniBand/200 Gb 以太网,双向带宽峰值高达 500 GB/s;

两块 64 核 AMD CPU 和 2 TB 系统内存,能够以 3.2 倍核心数量满足超密集的 AI 作业

30 TB 第四代 NVME SSD,带宽峰值高达 50 GB/s,比三代 NVME SSD 快两倍

Mellanox网络节点

AI数据中心采用Mellanox QM8700 IB交换机建立高速AI网络系统,QM8700采用Mellanox Quantum InfiniBand技术构建,可提供多达40个200Gb/s端口,每个端口具有全双向带宽。这些独立交换机是机架顶部叶连接或构建小型到超大规模集群的理想选择。QM8700是世界上最智能的网络交换机,旨在通过协同设计可伸缩层次聚合和缩减协议(SHARP)技术实现网络计算。协同设计体系结构允许使用所有活动数据中心设备来加速使用嵌入式硬件的通信框架,从而实现数量级的应用程序性能改进。

DDN存储节点

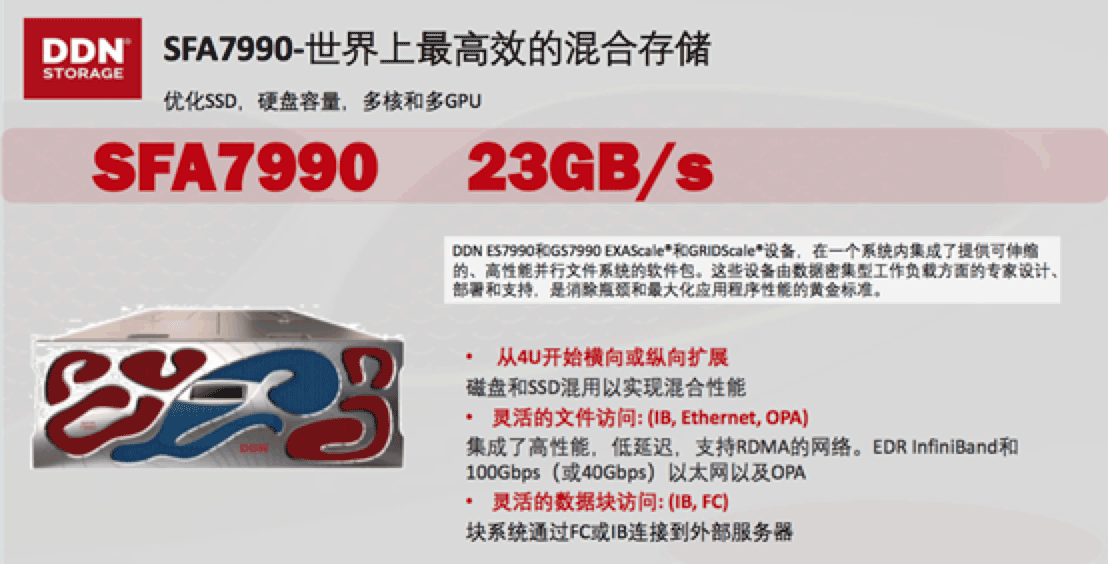

AI数据中心的存储节点由DDN公司的AI7990存储平台搭建,AI7990基于DDN A³I (加速的、任意规模的AI )的、专为NVIDIA DGX超级计算服务器而构建的并行存储平台,此系统经NVIDIA美国总部认证,符合《NVIDIA DGX SuperPOD: Scalable Infrastructure for AI Leadership》所建议的技术架构。

AI7990是一种混合SSD/HDD设备,支持高达5.4 PB的存储容量。单个设备可以提供70万IOPS、20 GB/s的顺序读取速率和16 GB/s的顺序写入速率。为了将这些设备与NVIDIA DGX服务器集成,DDN开发了运行在NVIDIA服务器上的客户端EXAscaler软件,以提供对存储设备的并行文件访问,多台DGX服务器可共享单台DDN设备,也可以使用多台DDN设备来提高存储容量和I/O性能。

三、算力服务

依托于AI数据中心硬件底层的强大算力,AI数据中心将立足无锡经开区,面向无锡市及长三角地区的AI行业用户提供全球领先的算力服务,加速用户业务发展,实现AI算力赋能。针对不同类型的用户,AI数据中心也将提供不同类型的折扣,让用户以较为优惠的价格去使用AI数据中心的算力资源。

A类企业:适用于无锡市经开区认定和扶持的优质企业,将享受最大力度的算力服务折扣;

B类企业:适用于在无锡市注册和纳税的优质企业,将享受中等力度的算力服务折扣;

C类企业:适用于不满足A类和B类企业认定条件的其他企业,将享受基本力度的算力服务折扣